产品概述:

ErgoAI动作捕捉实训设备是面向具身智能、机器人工程、人工智能交互等前沿领域职业教育的核心实训载体,以光学、惯性等多模态动作捕捉技术为基石,深度融合三维空间动态定位、实时数据解算与智能算法优化,构建从人体动作精准采集、数据特征提取到智能体行为映射的全链路实践体系。

平台聚焦具身智能场景,助力学生掌握通过动作捕捉驱动机器人、虚拟智能体实现自然交互与自主决策的核心技术,深度理解生物运动与机器控制的协同逻辑。同时,配套模块化教学资源与项目化实训方案,将理论知识与具身智能应用开发紧密结合,让学生在实践中提升智能体动作规划、人机协同控制等创新能力,真正实现 “学技术、创应用” 的职业教育目标。

系统组成:

(1)ErgoLAB动作捕捉设备

通过高精度动作捕捉传感器精确捕捉人体或物体在三维空间中每一个关节角度、肌肉活动和整体姿态的运动细节,包括惯性动作捕捉测试仪、光学动作捕捉测试仪两类,可广泛应用于运动科学、康复医学、虚拟现实及用户体验等领域。

设备品类:

设备名称 | 设备介绍 |

Mars光学动作捕捉相机 | Mars系列动作捕捉镜头采用红外摄像头捕捉反光标识点,能够采集并生成精准、实时的动作信息,包括三维空间XYZ坐标、六自由度(6DoF)、关节角度、偏航角(Yaw)、横摇角(Roll)、俯仰角(Pitch)、欧拉角等数据,为机器人/无人机的位姿控制、运动规划提供连贯、流畅的动作数据基础。 |

Xsens MVN Link惯性动作捕捉仪 | Xsens Link高端运动捕捉套装,该套装由17个传感器组成,传感器被安装在紧身的莱卡材质服装上,可以提供高质量的数据记录。Xsens Link的20毫秒低延迟特性,实时应用程序和实时传输,同时具有低延迟率保证数据捕获和处理的时间非常短,可实时反馈和精确同步的虚拟现实、增强现实、动画制作、游戏开发以及体育训练等领域的实训教学。 |

ErgoLAB Motion 惯性动作捕捉 | ErgoLAB Motion可穿戴人体运动捕捉与人机工效分析系统是基于无线惯性传感技术的全身三维动作捕捉及工效学评价系统。ErgoLAB Motion系统结合了加速度传感器、陀螺仪、方位传感器实时采集人体动作,位置,速度,关节角度,扭矩等信息,对数据无损耗,结合可穿戴无线眼动仪、可穿戴无线脑电仪、以及无线人因传感器(肌电、心电、皮电、皮温、体温等)设备,既可以基于实验室进行模拟实验,也可完全脱离固定场地在野外真实世界进行现场研究。可实时显示被捕捉者的动作及各种测量数据,具有传统的人机工程分析系统以及人体动作捕捉系统无可比拟的优势。 |

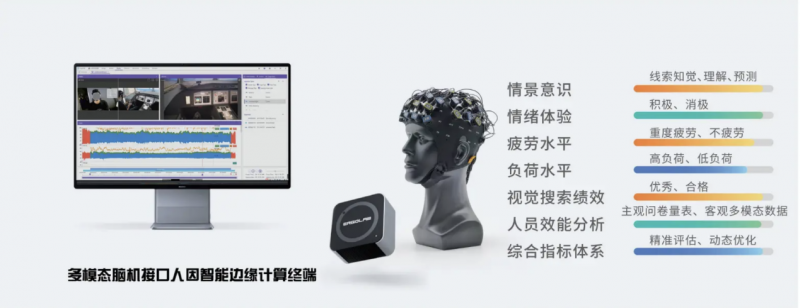

动作捕捉边缘计算终端 | 搭载边缘计算终端和智能算法模型,基于动捕数据对人体动作姿态进行实时监测预警,同时可以结合动作交互智能模型,灵活配置控制外设,满足多样化实训教学场景 |

设备特点:

l 高精度姿态捕捉:提供非常精确的三维空间数据,能够捕捉到人体的每一个微小的动作变化

l 实时数据反馈:提供实时数据输出,通过真人驱动3D虚拟模型进行可视化呈现,使研究人员能够即时观察和分析个体的运动表现。

l 无创性设计:设备采用非侵入式设计,对用户的身体无伤害,适合长时间监测

l 简单易用:操作简单、快速标定,可实现自动识别人体,一键数据修复,大幅提升自动化处理能力。

l 抗干扰能力强:具备良好的抗干扰性能,确保在复杂环境中也能获得准确、稳定的数据。

l 数据同步采集与可视化:基于ErgoAI人因智能平台进行动作姿态与其他多模态数据的同步采集,实时可视化监测个体的动作姿态并进行即时预警。

(2)数据采集、动作解码、3D可视化、动作分析模块

l 关节角度数据处理算法:自定义选择人体模型关节角度与数据处理,专业性动作姿态解码算法;

l 可视化3D数字人:通过3D数字人实时重塑三维运动模型

l 工效学姿势伤害评估:基于标准姿态数据库,可视化动作和姿势的实时风险评估与风险预警;

l 动作分析:动作编码分析、动作交叉分析、动作延迟分析、动作姿态可视化分析

(3)动作数据集、特征构建与模型训练、智能行为映射的人因智能模块

l 动作数据集管理:支持多源异构动作数据的整合与标注,提供标准化的动作数据分类体系

l 特征构建与模型训练:从原始动作数据中提取时空特征、动力学特征等有效信息,运用机器学习、深度学习算法构建高精度行为分析模型,实现对动作模式的识别、分类与预测。

l 智能行为映射:将训练好的模型输出结果映射至实际应用场景,如人机交互优化、行为异常检测、运动姿态矫正等,助力实现智能化人因工程设计与决策。

平台应用:

l 人机工效方向:动作捕捉实训设备通过精准采集人体运动数据,分析人体在不同工作场景下的动作姿态与运动规律,助力学生优化产品设计和工作流程布局。例如,在工业设计中,根据工人操作设备的动作数据,改进设备操作界面与操作方式,培养掌握人机工效学原理、能提升工作效率与舒适度的专业人才。

l 人机交互方向:依托动作捕捉技术,实训设备可实现人体动作与虚拟环境、智能设备的高效交互。学生能够学习将人体动作转化为控制指令,开发自然流畅的人机交互系统,如体感游戏、虚拟仿真教学系统,从而培养具备动作信号解析与交互系统设计能力的人才,推动人机交互方式的创新应用。

l 具身智能方向:该实训设备为具身认知与动作捕捉融合研究搭建实践平台。学生可以结合人体动作感知与动作捕捉技术,实现智能体对人类动作的模仿与协同,如机器人辅助康复训练、智能体协作作业,培养能推动具身智能发展的复合型人才。

ErgoLAB多模态同步方案:

整体概述

ErgoLAB人机环境同步平台采用多模态数据时钟同步技术,平台可完成完整的实验和测评流程,包括项目管理-试验设计-同步采集-信号处理-数据分析-人因智能评估-可视化报告,支持基于云架构技术的团体测试和大数据管理。

ErgoLAB人机环境同步平台采用主客观结合多模态数据同步采集与多维度验证的方法,数据实时同步种类包含大脑认知数据(EEG/BCI脑电仪与脑机接口边缘计算设备、fNIRS/BCI近红外脑成像仪),视觉数据(Eyetracker眼动仪与视线交互系统),生理数据(生理仪含:GSR/EDA、EMG、ECG、EOG、HRV、RESP、TEMP/SKT、PPG、SpO2),行为观察、肢体动作与面部表情(基本情绪、情绪效价、微表情等)数据、生物力学数据(拉力、握力、捏力、压力…),人机交互数据(包含人机界面交互行为数据以及对应的键盘操作,鼠标点击、悬浮、划入划出等;移动终端人机交互行为数据以及对应的手指轨迹操作行为如点击、缩放、滑动等;VR终端界面人机交互行为数据及对应的双手操作拾取、丢弃、控制,VR空间行走轨迹)、以及多类型时空行为轨迹数据采集(包括室内、户外、以及VR环境不同时空的行走轨迹、行车轨迹、访问状态以及视线交互、情感反应、交互操作行为等数据实时同步采集)、以及作业空间及作业环境数据(温度、湿度、噪音、光照、大气压、湿度、粉尘等)等客观量化数据;为科学研究及应用提供完整的数据指标。

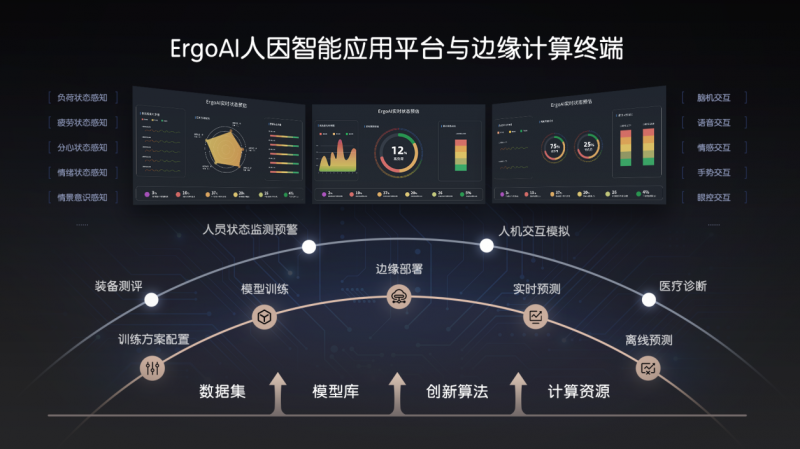

ErgoAI人因智能:

将人工智能技术引入人因工程研究工具,人因工程行业更加深度,使得实验环境不会受限于某一种设备或数据指标,采集分析不同典型行业或学科专业的人-机-环境系统交互过程中自然状态下的人类行为数据,获取更接近真实人员状态的数据。平台还提供覆盖科研实验全流程的功能模块,包括项目管理、实验设计、同步采集、数据分析、综合统计和可视化报告,结合ErgoAI人因智能边缘计算平台为多模态人机环境研究提供一站式人因工程+人工智能解决方案。以ErgoLAB人机环境同步平台和ErgoAI人因智能边缘计算平台为核心的多模态同步人因智能解决方案大大提高了实验结果的信效度,同时节省了研究的人力、物力、时间,提高了研究与测评的整体效率。

基于ErgoAI人因智能多元时序算法底座与人因工程人机环境数据库,构建人员特定状态的预训练模型,配合高灵活度的训练方案管理功能,用户能够在统一环境中高效构建和优化模型。 从而实现对人员状态的精准实时评估与预警,如负荷状态、应激状态、疲劳状态、情景意识和注意能力等。

Kingfar公司介绍:

北京津发科技股份有限公司(津发科技)是国家级专精特新“小巨人” ,新一轮第一批国家级专精特新重点“小巨人”、国家级知识产权优势企业、国家级高新技术企业、国家级科技型中小企业;旗下包含北京人因智能工程技术研究院和北京人因工程设计院有限公司等新型科技研发机构,并联合共建了北京市企业技术中心、北京本科高校产学研深度协同育人平台、苏州市重点实验室、湖南省工程实验室、山东省工程研究中心等多个科技创新平台。

津发科技承担和参与了多项国家重点研发计划、工信部高质量发展专项、国家自然科学基金等国家级课题基金项目。担任全国信标委XR扩展现实标准化工作组副组长单位,工信部元宇宙标准化工作组关键技术组联合组长单位;主持和参编国际、国家、行业和团体标准30余项。

津发科技创新研发了国产化自主可控的人因工程与人因智能边缘计算系列信创产品与技术;通过了欧洲CE、美国FCC、欧盟ROHS,以及ISO9001、ISO14001、ISO45001等多项国际认证。累计荣获30余项省部级新技术新产品认证和多项省部级科学技术奖励;全球申请发明专利超过530项,已授权120余项国际和国家发明专利、150余项国际和国家注册商标、130余项国家软件著作权;已服务全国高等院校和装备科技工业科研院所应用示范,并已支撑科研学者和科技工作者发表中英文学术论文超过1100篇。